本文の内容は、2024年9月19日に Nigel Douglas が投稿したブログ(https://sysdig.com/blog/owasp-top-10-for-llms/)を元に日本語に翻訳・再構成した内容となっております。

大規模言語モデル (LLM) アプリケーション向けの OWASP Top 10 は、基本的にソフトウェア開発者、セキュリティアーキテクト、その他の実践者を対象に、LLM セキュリティを強化し、より安全な AI ワークロードを実装する方法を教育するために設計されました。

このフレームワークは、これまでに確認されたLLMにおける最も重大な脆弱性を明確に挙げ、それらを軽減する方法を提示することで、LLMアプリケーションの展開や管理に伴う潜在的なセキュリティリスクを特定しています。

OWASP Top 10 for LLMsのようなオープンソースのリスク管理プロジェクトの必要性と利点を文書化したリソースが Web 上に多数あります。

しかし、多くの実務者は、組織内で Generative AI (GenAI) テクノロジーの展開をより適切に管理するために、部門横断的なチームをどのように連携すればよいかを見極めるのに苦労しています。また、GenAI ワークロードの安全な展開を支援するために、包括的なセキュリティコントロールも必要です。

そして最後に、これらのプロジェクトが、CISO などのセキュリティ リーダーが、LLM 向け OWASP Top 10 と、MITRE ATT&CK やMITRE ATLASなどのさまざまな業界の脅威マッピングフレームワークとの固有の違いをより深く理解するのにどのように役立つかについて、教育的なニーズがあります。

AI、ML、LLMの違いを理解する

人工知能(AI)は、過去数十年にわたり飛躍的な成長を遂げてきました。例えば、アイザック・アシモフが彼のSFの概念「ロボット工学三原則」を発表した翌年である1951年まで遡ると、クリストファー・ストレイチーがチェッカー(英国ではドラフツと呼ばれる)をプレイする最初のAIプログラムを作成しました。

AI は、機械が人間の行動に似たタスクを実行できるようにするコンピューターサイエンスのすべての分野を網羅する広範な用語ですが、機械学習 (ML) と GenAI は、AI の明確に定義された 2 つのサブカテゴリーです。

ML は GenAI に置き換えられたわけではなく、独自の特定のユースケースによって定義されています。ML アルゴリズムは、一連のデータでトレーニングされ、そのデータから学習し、最終的には予測を行うために使用されることがよくあります。これらの統計モデルは、天気を予測したり、異常な動作を検出したりするために使用できます。これらは依然として金融/銀行システムの重要な部分であり、望ましくない動作を検出するためにサイバーセキュリティで定期的に使用されています。

一方、GenAI は新しいデータを作成するタイプの ML です。GenAI は多くの場合、LLM を使用して既存のデータを合成し、それを使用して新しいものを作成します。例としては、ChatGPT やSysdig Sage TMなどのサービスがあります。AI エコシステムが急速に進化するにつれて、組織はクラウドネイティブ環境や Kubernetes 環境に Llama 2、Midjourney、ElevenLabs などの GenAI ソリューションを導入し、クラウドでの高いスケーラビリティとシームレスなオーケストレーションの利点を活用するケースが増えています。

この変化により、AI ワークロードを保護できる堅牢なクラウドネイティブ セキュリティ フレームワークの必要性が高まっています。この文脈において、AI、機械学習(ML)、およびLLMの違いを理解することは、セキュリティの影響や、それらを効果的に管理するためのガバナンスモデルを理解する上で重要です。

OWASP Top 10 と Kubernetes

企業が Llama などのツールをクラウド ネイティブ環境に統合する際、これらの AI ワークロードを効率的に管理するために Kubernetes などのプラットフォームに依存することがよくあります。クラウド ネイティブインフラストラクチャーへの移行により、OWASP Top 10 for Kubernetesや、より広範なOWASP Top 10 for Cloud-Native Systems ガイダンスで強調されているように、新たな複雑さが生じます。

Kubernetes が提供する柔軟性と拡張性により、GenAI モデルの導入と拡張が容易になりますが、これらのモデルは組織にまったく新しい攻撃対象領域をもたらします。セキュリティリーダーはこの点に留意する必要があります。クラウド プラットフォームで実行されるコンテナ化された AI モデルは、従来のオンプレミス導入や他のクラウド ネイティブのコンテナ化された環境とはまったく異なる一連のセキュリティ上の懸念事項の影響を受けます。このため、この急速な AI 導入に関連するリスクを適切に可視化するための包括的なセキュリティツールの必要性が改めて示されています

信頼できるAIを構築し運用する責任は誰にあるのか?

今後数年間、GenAI の新たなメリットが次々と発表され、提案されたメリットごとに、対処すべき新たなセキュリティ上の課題が生まれます。信頼できる AI には、信頼性と回復力があり、社内データだけでなく機密性の高い顧客データのセキュリティ保護に責任を持つ必要があります。

現在、多くの組織は、 LLM システムへの信頼に対する責任を真剣に負う前に、 EU AI 法などの政府規制が施行されるのを待っています。規制の観点から見ると、EU AI 法は実際には最初の包括的な AI 法ですが、実施に予期せぬ遅れがない限り、2025 年にのみ発効します。EU の一般データ保護規則 (GDPR) は LLM の使用を念頭に置いて考案されたものではないため、その広範な適用範囲は、データ収集、データ セキュリティ、公平性と透明性、正確性と信頼性、説明責任の一般原則の形でのみ AI システムに適用されます。

これらの GPDR 原則は、組織が GenAI の適切な使用に対してある程度の責任を持つのに役立ちますが、公式のAI ガバナンスを求める競争が明らかに進化しており、私たち全員がその答えを待ち望んでいます。最終的には、信頼できる AI に対する責任は、開発者、セキュリティ エンジニアリングチーム、およびリーダーシップの共同責任にあります。なぜなら、EU AI 法などの政府規制がコンプライアンスを強制するのを待つのではなく、AI システムが信頼性が高く、安全で、倫理的であることを積極的に保証する必要があるからです。

LLMにセキュリティとガバナンスを組み込む

EU の計画とは異なり、米国では AI 規制はより広範な既存の消費者プライバシー法に含まれています。では、AI のガバナンス標準が正式に定義されるまでの間、私たちは何をすればよいのでしょうか。アドバイスはシンプルです。既存の確立されたプラクティスとコントロールを実装するべきです。GenAI はサイバーセキュリティ、レジリエンス、プライバシー、および法的および規制上の要件への準拠に新たな側面を追加しますが、長年使用されてきたベストプラクティスは依然として、問題を特定し、脆弱性を見つけて修正し、潜在的なセキュリティ問題を軽減するための最良の方法です。

AI資産インベントリ

AI 資産インベントリは、社内で開発されたAI ソリューションと外部またはサードパーティの AI ソリューションの両方に適用する必要があることを理解することが重要です。そのため、特定の AI インベントリの資産管理でタグを指定して、既存の AI サービス、ツール、所有者をカタログ化する必要があることは明らかです。Sysdig のアプローチは、組織がAI コンポーネントをソフトウェア部品表 (SBOM) にシームレスに含めるのにも役立ち、セキュリティチームが GenAI ワークロードに関連付けられているすべてのソフトウェアコンポーネント、依存関係、メタデータの包括的なリストを生成できるようにします。データの機密性 (保護、機密、公開) に基づいて AI データソースを任意のSysdig ゾーンにカタログ化することで、セキュリティ チームはリスクの重大度レベルに基づいてそれらの AI ワークロードをより適切に優先順位付けできます。

ポスチャー管理

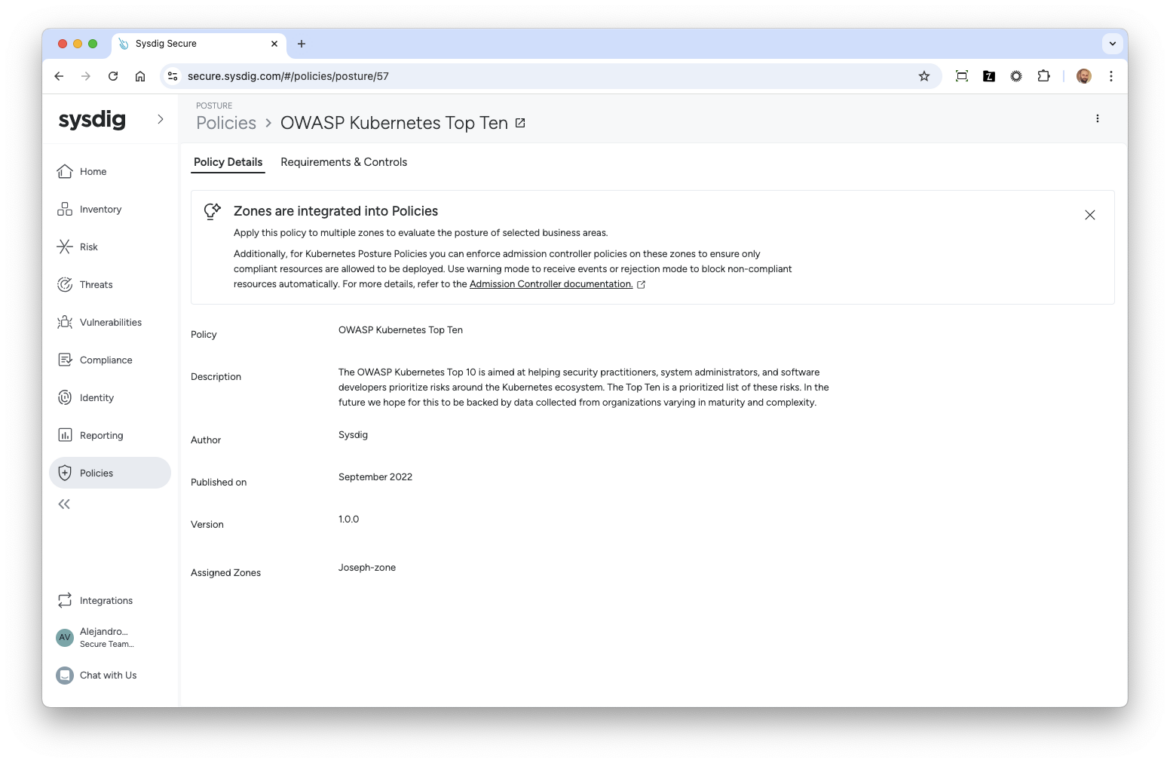

ポスチャーのの観点から、OWASP Top 10の結果を適切に報告するツールを持つべきです。Sysdigを使用すれば、これらのレポートは事前にパッケージ化されているため、エンドユーザーがカスタム設定を行う必要がなく、レポート作成が迅速化され、より正確なコンテキストが提供されます。特に、Kubernetes上で稼働するLLMベースのワークロードについて言及しているため、Kubernetes向けのOWASP Top 10で強調されているさまざまなセキュリティポスチャーコントロールに準拠していることを確実にすることが依然として重要です。

さらに、企業のLLMセキュリティ戦略をMITRE ATLASに連携・マッピングすることで、現在のプロセス(APIセキュリティ標準など)によってどこまでLLMセキュリティがカバーされているか、また追加のセキュリティホールがどこに存在するかをより正確に把握できるようになります。MITRE ATLAS(Artificial Intelligence Systemsにおける対敵脅威の全体像)は、悪意のあるアクターによるMLシステムへの実際の攻撃事例に基づいた知識ベースです。OWASP Top 10 for LLMsがLLMのプロアクティブなセキュリティ戦略を強化するための指針を提供する一方で、MITRE ATLASの発見結果は、FalcoやSysdigの脅威検出ルールと連携させることで、MITRE ATT&CKのアーキテクチャーに基づく戦術、技術、手順(TTPs)をより深く理解するのに役立ちます。

まとめ

LLMベースのワークロードをクラウドネイティブ環境に導入することで、企業の既存の攻撃対象領域が拡大します。OWASP Top 10 for LLM Applicationsの公式リリースで示されているように、これは新たな課題をもたらし、MITRE ATLASのようなフレームワークから特別な戦術と防御策が必要になります。

Kubernetes上で稼働するAIワークロードも、既知の問題に似た課題を提示しますが、OWASP Top 10 for Kubernetesなど、すでに確立されたサイバーセキュリティポストレポートや手順、軽減戦略が活用できる部分もあります。OWASP Top 10 for LLMを既存のクラウドセキュリティ管理、プロセス、および手順に統合することで、進化する脅威への露出を大幅に減らすことができるはずです。

もしこの情報が役に立ち、GenAIセキュリティについてもっと学びたいと感じたら、当社のCTOであるLoris DegioanniがThe CyberwireのDave Bittnerと語る「ジェネレーティブAIの世界における善と悪」についての対談をぜひチェックしてください。